Giỏ hàng

0 Sản Phẩm

Trong bối cảnh trí tuệ nhân tạo bùng nổ, các doanh nghiệp và tổ chức nghiên cứu ngày càng cần đến những nền tảng tính toán mạnh mẽ để xử lý dữ liệu khổng lồ và huấn luyện mô hình AI thế hệ mới. Để đáp ứng nhu cầu này, NVIDIA H100 ra đời như một giải pháp đột phá, mang lại sức mạnh vượt trội cho AI, HPC và điện toán đám mây. GPU này không chỉ tạo nên tiêu chuẩn mới cho hiệu năng mà còn mở ra khả năng triển khai AI ở quy mô chưa từng có.

NVIDIA H100 là GPU thế hệ Hopper mới nhất, kế nhiệm A100, được thiết kế chuyên biệt cho AI, HPC (High Performance Computing), Data Center và Cloud. Với kiến trúc tiên tiến, H100 giúp tăng tốc xử lý mô hình trí tuệ nhân tạo, đào tạo mạng neural, mô phỏng khoa học, và nhiều tác vụ tính toán phức tạp khác.

GPU NVIDIA H100 Tensor Core mang lại hiệu năng, khả năng mở rộng và bảo mật vượt trội cho mọi khối lượng công việc. H100 sử dụng những cải tiến đột phá dựa trên kiến trúc NVIDIA Hopper™ để mang đến AI đàm thoại hàng đầu trong ngành, tăng tốc các mô hình ngôn ngữ lớn (LLM) lên gấp 30 lần. H100 cũng bao gồm một Transformer Engine chuyên dụng để giải quyết các mô hình ngôn ngữ nghìn tỷ tham số.

| H100 SXM | H100 NVL | |

|---|---|---|

| FP64 | 34 teraFLOPS | 30 teraFLOP |

| Lõi Tensor FP64 | 67 teraFLOPS | 60 teraFLOP |

| FP32 | 67 teraFLOPS | 60 teraFLOP |

| Lõi Tensor TF32 * | 989 teraFLOPS | 835 teraFLOP |

| Lõi Tensor BFLOAT16 * | 1.979 teraFLOPS | 1.671 teraFLOPS |

| Lõi Tensor FP16 * | 1.979 teraFLOPS | 1.671 teraFLOPS |

| Lõi Tensor FP8 * | 3.958 teraFLOPS | 3.341 teraFLOPS |

| Lõi Tensor INT8 * | 3.958 TOPS | 3.341 TOPS |

| Bộ nhớ GPU | 80GB | 94GB |

| Băng thông bộ nhớ GPU | 3,35TB/giây | 3,9TB/giây |

| Bộ giải mã | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| Công suất thiết kế nhiệt tối đa (TDP) | Lên đến 700W (có thể cấu hình) | 350-400W (có thể cấu hình) |

| GPU đa phiên bản | Tối đa 7 MIGS @ 10GB mỗi MIGS | Tối đa 7 MIGS @ 12GB mỗi MIGS |

| Yếu tố hình thức | SXM | PCIe khe cắm kép làm mát bằng không khí |

| Kết nối | NVIDIA NVLink™: 900GB/giây PCIe Gen5: 128GB/giây |

NVIDIA NVLink: 600GB/giây PCIe Gen5: 128GB/giây |

| Tùy chọn máy chủ | Đối tác NVIDIA HGX H100 và Hệ thống được chứng nhận NVIDIA ™ với 4 hoặc 8 GPU NVIDIA DGX H100 với 8 GPU |

Đối tác và Hệ thống được NVIDIA chứng nhận với 1–8 GPU |

| NVIDIA AI Enterprise | Tiện ích bổ sung | Đã bao gồm |

Điểm then chốt giúp NVIDIA H100 tạo khác biệt chính là kiến trúc Hopper – thế hệ GPU mới thay thế kiến trúc Ampere trên A100. Hopper là GPU đầu tiên của NVIDIA hỗ trợ chuẩn FP8 (độ chính xác 8-bit), thay vì chỉ FP16 hay FP32 như trước. Điều này đặc biệt hữu ích cho AI generative và các mô hình ngôn ngữ lớn (LLMs), bởi nó cho phép xử lý khối lượng dữ liệu khổng lồ nhanh hơn nhiều mà vẫn giữ độ chính xác cần thiết.

Ngoài ra, Hopper còn tích hợp Transformer Engine – công nghệ độc quyền của NVIDIA. Transformer Engine có khả năng tự động lựa chọn độ chính xác FP8 hoặc FP16 phù hợp cho từng phép tính, giúp cân bằng tối ưu giữa tốc độ và độ chính xác. Đây chính là lý do H100 trở thành GPU lý tưởng để huấn luyện các mô hình AI thế hệ mới như GPT, BERT hay Stable Diffusion.

>>> Có thể bạn quan tâm đến: Top các máy chủ gpu nvidia tốt nhất 2025

Sức mạnh vượt trội: So với thế hệ A100, NVIDIA H100 có hiệu năng xử lý AI tăng gấp nhiều lần, đặc biệt ở các tác vụ huấn luyện mô hình ngôn ngữ lớn (LLMs) và AI Generative. Điều này giúp rút ngắn thời gian đào tạo mô hình từ vài tuần xuống chỉ còn vài ngày.

Công nghệ Transformer Engine: Đây là điểm nhấn quan trọng trong kiến trúc Hopper. Transformer Engine giúp tối ưu tính toán FP8 và FP16, nhờ đó tăng tốc đáng kể các mô hình AI thế hệ mới như GPT, BERT hoặc các hệ thống xử lý ngôn ngữ tự nhiên khác.

Băng thông bộ nhớ HBM3: Với dung lượng bộ nhớ lên đến 80GB cùng băng thông 3TB/s, H100 có khả năng xử lý khối dữ liệu khổng lồ trong thời gian ngắn, đặc biệt phù hợp với các tác vụ Big Data và mô phỏng khoa học phức tạp.

Multi-Instance GPU (MIG): Công nghệ này cho phép chia nhỏ GPU thành nhiều phân vùng độc lập. Mỗi phân vùng có thể phục vụ workload khác nhau mà vẫn đảm bảo hiệu năng và bảo mật, giúp doanh nghiệp tối ưu hóa hạ tầng và tiết kiệm chi phí.

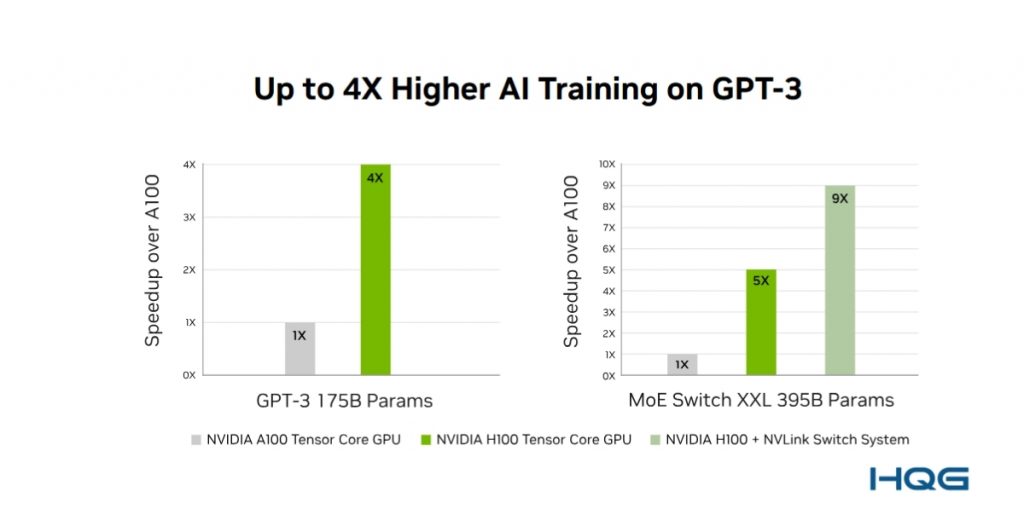

Theo công bố từ NVIDIA, H100 cho hiệu năng AI cao gấp 3-4 lần ở huấn luyện mô hình và tới 9 lần ở tác vụ suy luận nhờ Transformer Engine. Ngoài ra, H100 hỗ trợ chuẩn tính toán FP8 mà A100 không có, giúp giảm chi phí và năng lượng tiêu thụ cho mỗi mô hình.

Một điểm khác biệt quan trọng là băng thông bộ nhớ: H100 trang bị HBM3 với tốc độ 3TB/s, trong khi A100 chỉ dừng ở HBM2e với khoảng 2TB/s. Điều này cho phép H100 xử lý những workload dữ liệu khổng lồ mà A100 có thể gặp giới hạn.

Nhờ các cải tiến này, nhiều trung tâm dữ liệu đang dần thay thế A100 bằng H100 để đảm bảo hạ tầng đủ mạnh cho thế hệ AI mới.

NVIDIA H100 được ứng dụng rộng rãi trong nhiều lĩnh vực. Trong AI và machine learning, H100 là GPU lý tưởng để huấn luyện và suy luận các mô hình ngôn ngữ lớn cũng như hệ thống thị giác máy tính, đứng sau những công cụ như ChatGPT, Stable Diffusion hay Bard.

Trong y tế, H100 tăng tốc mô phỏng protein, phân tích gen và nghiên cứu thuốc, giúp rút ngắn đáng kể thời gian phát triển sản phẩm mới. Với HPC, GPU này hỗ trợ các bài toán phức tạp như mô phỏng khí hậu, nghiên cứu vật lý hạt nhân hay thiết kế năng lượng sạch, vốn cần hàng triệu giờ tính toán.

Đối với các ngành khoa học và HPC, H100 đóng vai trò quan trọng trong việc giải quyết những bài toán phức tạp như mô phỏng khí hậu, nghiên cứu vật lý hạt nhân hay thiết kế năng lượng sạch. Các mô phỏng vốn yêu cầu hàng triệu giờ tính toán trên siêu máy tính giờ đây có thể được thực hiện nhanh chóng và hiệu quả hơn nhờ H100.

Ở mảng trung tâm dữ liệu và cloud, các nhà cung cấp lớn như AWS, Azure hay Google Cloud đã tích hợp H100, mang đến cơ hội cho doanh nghiệp và startup khai thác sức mạnh GPU hàng đầu mà không cần đầu tư trực tiếp phần cứng.

Việc triển khai H100 ở quy mô trung tâm dữ liệu giúp đưa khả năng tính toán chạm mốc exascale, mở ra khả năng xử lý mô hình AI với hàng nghìn tỷ tham số. Điều này làm vượt lên giới hạn Moore’s Law, giúp các phòng thí nghiệm nghiên cứu và tổ chức học thuật đẩy nhanh tốc độ khám phá khoa học và AI.

H100 hỗ trợ phân vùng GPU (Multi-Instance GPU – MIG) thành nhiều phần độc lập, cho phép cùng một GPU phục vụ nhiều workload khác nhau. Đi kèm là tính năng Confidential Computing, bảo vệ dữ liệu ngay cả khi đang xử lý, rất phù hợp cho các ngành như tài chính, y tế hoặc chính phủ.

H100 không chỉ giúp xử lý dữ liệu nhanh hơn mà còn tiết kiệm chi phí khi triển khai ở quy mô lớn. Với hiệu năng/watt cao, khả năng mở rộng linh hoạt nhờ MIG và hỗ trợ từ phần mềm NVIDIA AI Enterprise (đặc biệt đối với phiên bản PCIe), GPU này giúp doanh nghiệp tối ưu chi phí đầu tư và vận hành.

H100 được trang bị NVLink thế hệ mới với tốc độ kết nối lên đến 900 GB/s (hoặc 600 GB/s tùy form factor), cho phép nhiều GPU hoạt động như một “siêu GPU.” Khi kết hợp với NVSwitch, hệ thống có thể mở rộng hàng trăm GPU trong cụm, đáp ứng được yêu cầu huấn luyện mô hình AI lớn nhất

Điểm nổi bật là H100 hỗ trợ hạ tầng kết nối tốc độ cao như NVLink thế hệ mới và PCIe Gen5, đảm bảo băng thông vượt trội khi kết hợp nhiều GPU song song. Nhờ đó, các hệ thống có thể dễ dàng mở rộng mà không bị nghẽn cổ chai – điều cực kỳ quan trọng trong xử lý AI quy mô lớn.

Ngoài ra, H100 cũng đi đầu trong tối ưu năng lượng. So với hiệu năng mang lại, mức tiêu thụ điện của H100 thấp hơn đáng kể so với việc phải duy trì nhiều GPU thế hệ cũ. Đây là yếu tố then chốt trong bối cảnh trung tâm dữ liệu ngày càng chú trọng đến phát triển bền vững.

Chính sự kết hợp giữa hiệu năng, khả năng mở rộng, tính linh hoạt và hiệu quả năng lượng đã giúp NVIDIA H100 trở thành nền tảng GPU hàng đầu, được các tổ chức nghiên cứu, doanh nghiệp công nghệ và nhà cung cấp dịch vụ đám mây hàng đầu thế giới tin dùng.

HQG là nhà cung cấp Server AI NVIDIA, thiết bị IT hàng đầu tại Việt Nam. Việc xây dựng một hệ thống AI hiện đại tưởng chừng phức tạp. Sự đồng hành của HQG và các đối tác chiến lược như Dell và NVIDIA, quá trình đó có thể trở nên rõ ràng và hiệu quả hơn rất nhiều. Ngoài ra, một giải pháp tiết kiệm hơn đó chính là thuê server nếu bạn có giới hạn về kinh phí.

NVIDIA H100 không chỉ là GPU mạnh mẽ nhất của NVIDIA ở thời điểm hiện tại mà còn là chìa khóa để mở ra kỷ nguyên mới cho AI, HPC và điện toán đám mây. Với hiệu năng vượt trội, khả năng mở rộng linh hoạt và ứng dụng thực tế rộng rãi, H100 đang trở thành lựa chọn hàng đầu cho doanh nghiệp và tổ chức muốn đi trước trong cuộc đua công nghệ.

Nếu bạn đang quan tâm đến giải pháp hạ tầng GPU mạnh mẽ cho AI, Data Center hay các dự án nghiên cứu chuyên sâu, HQG sẵn sàng đồng hành và tư vấn giải pháp NVIDIA H100 tối ưu nhất cho nhu cầu của bạn. Liên hệ ngay với HQG để được hỗ trợ chi tiết và trải nghiệm sức mạnh thực sự của dòng GPU Hopper hàng đầu thế giới.

Liên hệ HQG ngay hôm nay để được hỗ trợ 24/7! Tư vấn miễn phí giải pháp AI phù hợp nhất cho riêng bạn!

Website: https://hqg.vn/

Fanpage: Facebook | LinkedIn | YouTube | TikTok

Hotline: 0922 999 111 | Email: info@hqg.vn

Trụ sở: 8 Nguyễn Duy, Phường Gia Định, TP. Hồ Chí Minh, Việt Nam.

VPGD Hồ Chí Minh: Lô O, số 10, Đ.15, KDC Miếu Nổi, Phường Gia Định, TP. Hồ Chí Minh.

VPGD Đà Nẵng: 30 Nguyễn Hữu Thọ, Phường Hải Châu, Đà Nẵng.

VPGD Hà Nội: 132 Vũ Phạm Hàm, Phường Yên Hoà, Hà Nội.