Giỏ hàng

0 Sản Phẩm

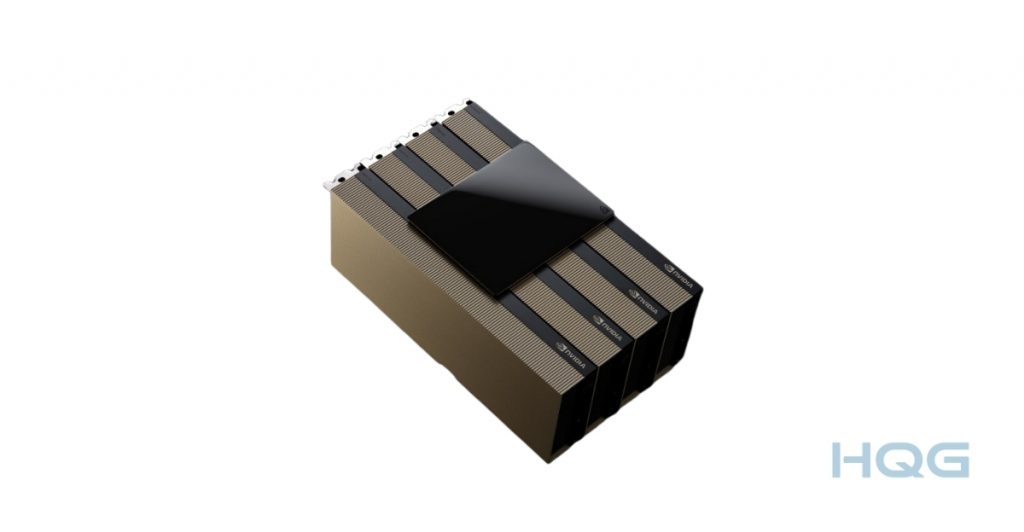

Nvidia H200 Tensor Core GPU là dòng card mới nhất của Nvidia. Khi các mô hình AI ngày càng lớn và phức tạp, doanh nghiệp cũng cần một hạ tầng GPU đủ mạnh để vừa đào tạo AI, vừa xử lý dữ liệu tính toán hiệu năng cao (HPC) một cách trơn tru.

HQG nhà cung cấp giải pháp Server AI chính hãng. Máy chủ trí tuệ nhân tạo (AI) giúp rút ngắn thời gian xử lý, giảm chi phí và tăng tốc mọi ứng dụng AI hoặc HPC. Cùng HQG khám phá GPU Nvidia H200 chi tiết, lợi ích, thông số kỹ thuật, và những điểm quan trọng bạn nên biết!

H200 là GPU đầu tiên của Nvidia sử dụng bộ nhớ HBM3e – chuẩn bộ nhớ băng thông cực cao mới nhất. So với thế hệ tiền nhiệm H100, H200 sở hữu 141 GB bộ nhớ HBM3e (tăng gần gấp đôi) và đạt tốc độ 4.8 TB/s (tăng 1.4 lần). Đây là yếu tố then chốt giúp các mô hình AI lớn như Llama2, GPT, Claude hay Mistral được xử lý nhanh hơn với độ trễ thấp hơn.

Theo công bố từ Nvidia, H200 cho hiệu năng inference tăng đến 1.9 lần với Llama2 (70B) và 1.6 lần với GPT-3 (175B) so với H100, mà vẫn giữ nguyên cấu trúc phần cứng. Điều này giúp doanh nghiệp tiết kiệm điện năng, tận dụng hạ tầng hiện có và mở rộng theo nhu cầu.

Đặc biệt, H200 tương thích với toàn bộ hệ sinh thái phần mềm của Nvidia như CUDA, cuDNN, TensorRT và Nvidia AI Enterprise – thuận tiện khi triển khai từ hạ tầng on-premise đến multi-cloud.

Nvidia H200 Tensor Core không chỉ là GPU mạnh – nó là bước tiến lớn cho AI tạo sinh (generative AI) và tính toán hiệu năng cao (HPC). Được xây dựng trên kiến trúc Hopper, H200 là GPU đầu tiên trang bị 141 GB bộ nhớ HBM3e siêu nhanh, đạt băng thông tới 4.8 TB/s – gần gấp đôi dung lượng và nhanh hơn 40% so với H100. Kết quả: AI chạy nhanh hơn, xử lý dữ liệu lớn mượt hơn, và tiết kiệm điện năng hơn.

Các mô hình như Llama2, GPT-3, Claude hay Gemini đều cần sức mạnh xử lý lớn để đưa ra phản hồi nhanh và chính xác. Nvidia H200 cho thấy hiệu năng inference gấp 2 lần so với H100 khi xử lý các mô hình LLM cỡ lớn. Điều này đặc biệt quan trọng khi doanh nghiệp triển khai AI ở quy mô lớn, phục vụ hàng triệu người dùng với chi phí thấp nhất có thể.

Với các ứng dụng như mô phỏng vật lý, phân tích y sinh, hoặc nghiên cứu khí hậu, băng thông bộ nhớ là yếu tố sống còn. H200 giúp tăng tốc các phần mềm HPC phổ biến như GROMACS, Quantum Espresso, MILC, ICON đến 110 lần so với máy chủ CPU truyền thống – rút ngắn thời gian mô phỏng từ hàng giờ xuống còn vài phút.

Dù mạnh hơn đáng kể, H200 vẫn giữ nguyên mức tiêu thụ điện như H100. Nhờ đó, các trung tâm dữ liệu AI có thể nâng cấp hiệu suất mà không cần thay đổi hạ tầng điện lạnh – vừa thân thiện với môi trường, vừa tối ưu chi phí vận hành (TCO).

Tóm lại, Nvidia H200 không chỉ mạnh ở con số, mà thực sự mang lại giá trị kinh tế và tốc độ triển khai AI rõ rệt cho doanh nghiệp. Từ inference nhanh hơn, mô phỏng khoa học chính xác hơn, đến chi phí hạ tầng thấp hơn – H200 đang mở đường cho một thế hệ ứng dụng AI mạnh mẽ và dễ tiếp cận hơn bao giờ hết.

Với doanh nghiệp đang triển khai AI ở quy mô thực tế, hiệu suất và khả năng mở rộng là yếu tố sống còn. NVIDIA H200 NVL được thiết kế đặc biệt cho các hệ thống rack tiêu chuẩn, sử dụng tản nhiệt bằng khí, tiêu thụ điện thấp nhưng vẫn đủ mạnh để xử lý các tác vụ AI và HPC nặng nhất hiện nay.

Nhờ kết nối tối đa 4 GPU qua NVIDIA NVLink™, cùng bộ nhớ tăng 1.5 lần so với H100 NVL, H200 có thể tăng tốc inference của mô hình ngôn ngữ lớn (LLM) lên đến 1.7 lần, và cải thiện hiệu suất HPC thêm 30%. Điều này giúp doanh nghiệp tiết kiệm thời gian đào tạo mô hình và rút ngắn thời gian phản hồi trong các ứng dụng AI thực tế.

Không chỉ mạnh về phần cứng, H200 NVL còn đi kèm gói phần mềm NVIDIA AI Enterprise bản quyền 5 năm. Đây là bộ công cụ toàn diện giúp các nhóm kỹ thuật dễ dàng triển khai các giải pháp AI tạo sinh, thị giác máy tính, nhận diện giọng nói, hay ứng dụng kết hợp tìm kiếm thông minh (RAG)… trong môi trường doanh nghiệp.

Với sự hỗ trợ của NVIDIA NIM™ – bộ microservice đơn giản, nhẹ và dễ tích hợp – doanh nghiệp có thể nhanh chóng đưa các ứng dụng AI vào vận hành, đảm bảo tính bảo mật, ổn định và dễ quản lý. Tất cả được tối ưu để mang lại giá trị kinh doanh nhanh hơn và kết quả rõ ràng hơn từ dữ liệu.

NVIDIA H200 có hai phiên bản: SXM và NVL. Bản H200 SXM dùng chuẩn SXM socket, gắn trực tiếp vào mainboard HGX, tối ưu hiệu năng và băng thông trong các hệ thống AI chuyên dụng. Trong khi đó, H200 NVL là dạng card PCIe gồm 2 GPU ghép cặp qua NVLink, phù hợp với máy chủ phổ thông, dễ lắp đặt và mở rộng. Cả hai đều dùng HBM3e nhưng khác biệt rõ về thiết kế, kết nối và mục tiêu triển khai.

NVIDIA H200 SXM là dòng GPU AI hiệu năng cao dùng kiến trúc Hopper, hỗ trợ bộ nhớ HBM3e tốc độ siêu nhanh (4,8 TB/s), tối ưu cho các hệ thống SXM như HGX để xử lý mô hình AI lớn như LLM và HPC. H200 SXM thường được dùng trong các trung tâm dữ liệu cao cấp, đòi hỏi hiệu suất tính toán vượt trội và băng thông bộ nhớ cực lớn.

NVIDIA H200 NVL là phiên bản đặc biệt thiết kế theo dạng PCIe kép (dual-slot), tối ưu hóa cho AI inference và ứng dụng doanh nghiệp quy mô lớn. Mỗi bộ H200 NVL gồm 2 GPU kết nối nội bộ bằng NVLink Bridge, giúp tăng cường hiệu suất xử lý mà vẫn phù hợp với các hệ thống máy chủ tiêu chuẩn (không cần SXM).

| Thông số | H200 SXM | H200 NVL |

|---|---|---|

| FP64 | 34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core | 67 TFLOPS | 60 TFLOPS |

| FP32 | 67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core | 1,979 TFLOPS | 1,671 TFLOPS |

| FP16 Tensor Core | 1,979 TFLOPS | 1,671 TFLOPS |

| FP8 Tensor Core | 3,958 TFLOPS | 3,341 TFLOPS |

| INT8 Tensor Core | 3,958 TFLOPS | 3,341 TFLOPS |

| GPU Memory | 141 GB | 141 GB |

| GPU Memory Bandwidth | 4.8 TB/s | 4.8 TB/s |

| Decoders | 7 NVDEC, 7 JPEG | 7 NVDEC, 7 JPEG |

| Confidential Computing | Hỗ trợ | Hỗ trợ |

| Max TDP (Thiết kế nhiệt tối đa) | Lên đến 700W (tùy chỉnh) | Lên đến 600W (tùy chỉnh) |

| Multi-Instance GPUs | Lên đến 7 MIGs @ 18GB | Lên đến 7 MIGs @ 16.5GB |

| Form Factor | SXM | PCIe (dual-slot air-cooled) |

| Interconnect | NVLink: 900 GB/s, PCIe Gen5: 128 GB/s | 2-/4-way NVLink: 900 GB/s, PCIe Gen5: 128 GB/s |

| Server Options | NVIDIA HGX™ với 4 hoặc 8 GPUs | NVIDIA MGX™ với tối đa 8 GPUs |

| NVIDIA AI Enterprise | Mua thêm | Đã bao gồm |

Với kinh nghiệm triển khai hạ tầng GPU cho các tổ chức tài chính, giáo dục, AI startup và trung tâm dữ liệu tại Việt Nam, HQG là đối tác uy tín giúp doanh nghiệp nhanh chóng tiếp cận thế hệ GPU H200. Chúng tôi cung cấp giải pháp trọn gói từ tư vấn cấu hình, cung cấp server chính hãng, triển khai kỹ thuật đến hỗ trợ sau bán hàng:

– Tối ưu chi phí sở hữu (TCO): Nhờ chính sách nhập khẩu trực tiếp, HQG giúp khách hàng sở hữu server H200 với chi phí hợp lý nhất thị trường.

– Bảo hành và hỗ trợ 24/7: Dịch vụ kỹ thuật chuyên sâu, xử lý sự cố nhanh, đảm bảo hệ thống vận hành liên tục.

– Tư vấn giải pháp AI & HPC: HQG không chỉ bán thiết bị, chúng tôi đồng hành cùng khách hàng trong thiết kế, triển khai và tối ưu hạ tầng AI dài hạn.

Nếu doanh nghiệp bạn đang lên kế hoạch triển khai AI, nâng cấp hạ tầng cho R&D hoặc cần tăng tốc workload HPC, HQG sẵn sàng hỗ trợ tư vấn và cấu hình server GPU phù hợp với từng bài toán cụ thể. Doanh nghiệp nào nắm vững hạ tầng AI hôm nay, sẽ dẫn đầu thị trường ngày mai. Bạn đang tìm một giải pháp AI mạnh mẽ và bền vững cho doanh nghiệp? Liên hệ HQG ngay!

Website: https://hqg.vn/

Fanpage: Facebook | LinkedIn | YouTube | TikTok

Hotline: 0922 999 111 | Email: info@hqg.vn

Trụ sở: 8 Nguyễn Duy, Phường Gia Định, TP. Hồ Chí Minh, Việt Nam.

VPGD Hồ Chí Minh: Lô O, số 10, Đ.15, KDC Miếu Nổi, Phường Gia Định, TP. Hồ Chí Minh.

VPGD Đà Nẵng: 30 Nguyễn Hữu Thọ, Phường Hải Châu, Đà Nẵng.

VPGD Hà Nội: 132 Vũ Phạm Hàm, Phường Yên Hoà, Hà Nội.